こんにちは。にとあです。

このブログでは、画像生成AIの技術を駆使して

うちの子・ペットのアンゴラうさぎの「ニト」を主人公にした

デジタル絵本制作の過程を記録していきたいと思っています。

…とはいえ、本業やら何やらでなかなか時間が取れず、

今日からできる範囲でコツコツ記していくことにしました。

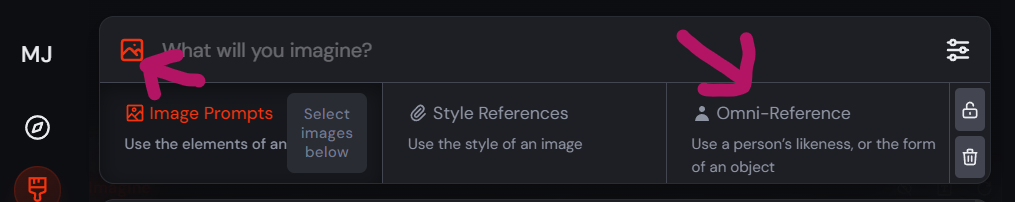

MidJourney v7の進化に感動

2025年5月頭、つい最近リリースされた MidJourneyのv7。

これが本当にすごいんです。

何が変わったかというと——

そもそもMidJourneyは生成画像の品質が素晴らしいのに加え、

「キャラの一貫性(固定化)」が、格段にやりやすくなった!

こんなかんじ

私自身、AI画像生成歴は浅く、約1ヶ月程度。まだ初心者ともいえる段階です。

とはいえ、画像生成はChatGPT、MidJourney V6、Scenarioなどの有料サービスに加え、

ローカル環境を構築してStable Diffusion、Khoya、SwarmUI、ComfyUI、

さらにチューニング力を高めるControl Netのアレコレなど、

ここ1ヶ月、興味が赴くままにいじりたおしました。

それでも、このMidJourney v7には驚かされました。

v7が出る前までは、Stable DiffusionなどでLoRA (モデル)を作成した上で

様々なモデルデータを使ってみたり、

細かくプロンプトやパラメータを調整したりと、色々試したものの、

ポーズや角度がちょっと変わるだけで、別のうさぎ、になってしまう…。

そんなのが当たり前だったんですよね。

人間と動物 ー AIの進化は動物が圧倒的に遅い?

特に「動物」はその傾向が顕著で、

人間はすでにたくさんの学習データがあるから、AI側も形状を把握しやすく、固定化されやすい。

でも、うさぎになると話は別。

そもそも、AIが「うさぎ」をどう見ているかも怪しいレベルでした。

たとえば:うさぎに肉球つけちゃう問題

本物のうさぎって、肉球がないんですよ。

(うさぎ飼いからすると当たり前ですが、知らない人も多いですよね?)

それなのに、MidJourney v7でさえも、注意しないと肉球を描いちゃう。

肉球程度ならまだしも、四肢の学習がまだ浅いのか、

耳が4本とか、手が6本になったり、尻尾がお団子になったりも、よくします。。

もはや別の何か。。。

つまり、動物の学習データは、現時点では、まだまだ進化が必要な状況なのかなと。

人気ペットの犬や猫の方が、データ量はずっと多いとは思います。

でも、犬は犬種によって形もかなり違うので、

犬種によってはうさぎと同じくらい生成が難しいかも?しれません。

LoRAだけでは難しかった「うちの子固定化」

…と、前置きが長くなってしまいましたが、

何が言いたいかというと、

今までは、「モデルの固定化=LoRA必須」だったということ。

LoRAとは、簡単にいうと、モデル学習のための画像集です。

最低でも30枚くらいの画像が必要に言われています。

でも、ペットのLoRAってハードル高くない?

実際のところ、動物の写真を上下左右30枚集めてLoRA化したところで

うまく固定化できなかったというのが私の感想です。

なぜなら……

どうぶつは、勝手気ままに動くからです!!!

背景学習の落とし穴

プロのカメラマンとかにお願いして、

真っ白な背景で360度撮影してもらえるなら話は別ですが、

実際は、いつもの部屋・飼育環境で撮影した30枚を使うことになりますよね。

すると:

- 背景を勝手に覚えてしまう

- 食器やマットなどがLoRAに混ざる

- 被写体の形状だけでなく、色や光の偏りまで学習されてしまう

こんなことが起きるわけです。

これはほぼ調整もしてない極端な例ですが、実写真からControl Netだけいじって生成した画像。

「ニトだけ」を抽出することはむずかしい。

ペット固定化は、人間キャラよりも難しい説

なので私は思いました。

「自分のペットの固定化」って、人間やキャラよりずっと難しいのでは…?

(誰か違うなら教えて!)

でもv7なら、コツさえ掴めば…

それでも、MidJourney v7では、ある程度コツを掴めば再現性が保てるようになってきたんです。

たとえば:

- 耳のグレーの入り方

- 白ふわの毛並み

- 目のハイライトの位置

こういった“特徴”をしっかりプロンプトで伝えれば、

びっくりするくらい「うちの子」っぽく出てきます。

( ※正しくは、「うちの子」のキャラクター化の固定 )

これはもう、ペットを愛してやまない全人類にとって…

革命的な出来事ではないでしょうか?

「絵心のない者が絵本を作る」なんて、ちょっと前までは来世でどうぞな夢物語だったのに、

今や誰でもここまでできる時代が来てしまったんだなぁと、実感しています。

肝心のキャラ固定化をする方法

具体的には大きく2つあります。

1:ペットの基本特徴を固定Prompt化として「毎回」しっかり伝えること

「耳毛グレーで、体がふわふわの白、黒い瞳に白いハイライト」など、

ペットの基本特徴を毎回固定化し、英語でしっかり伝えること、

その上で、今回表現したいポーズや情景などを細かく指定することで、毎回の生成に統一感が出やすいです。

これはMidJourney自体にはまだ、Loraという学習モデルがあるわけではないので、

Loraの代わりという感じでしょうか。

2:ChatGPTで生成した画像をモデルとして毎回差し込むこと

別にChatGPTであるのは必須ではないのですが、「ペット×イラスト」の場合、

ChatGPTが使いやすさ・気軽さの面でベストだと、私自身は考えています。

まず何より、「ペット自身の実写真から」、

自分のしたいテイストのイラストにキャラ化することを、非常に精度高くできます。

こんなかんじで。

この出力が気に入れば、これが毎回、Midjourney v7のOmni Referenceに差し込むベース画像となります。

Omni Referenceとは簡単にいうと、この画像をベースにキャラ作ってね、っていう参照画像。

Omni Reference自体にもパラメータがあって、高くすればするほど、

もとの画像をより強く参照しようとします。

私の所感だと、75~100くらいでも十分参照してくれますが、

これは何度も試して自分がFitする数値に調整していくと良いと思います。

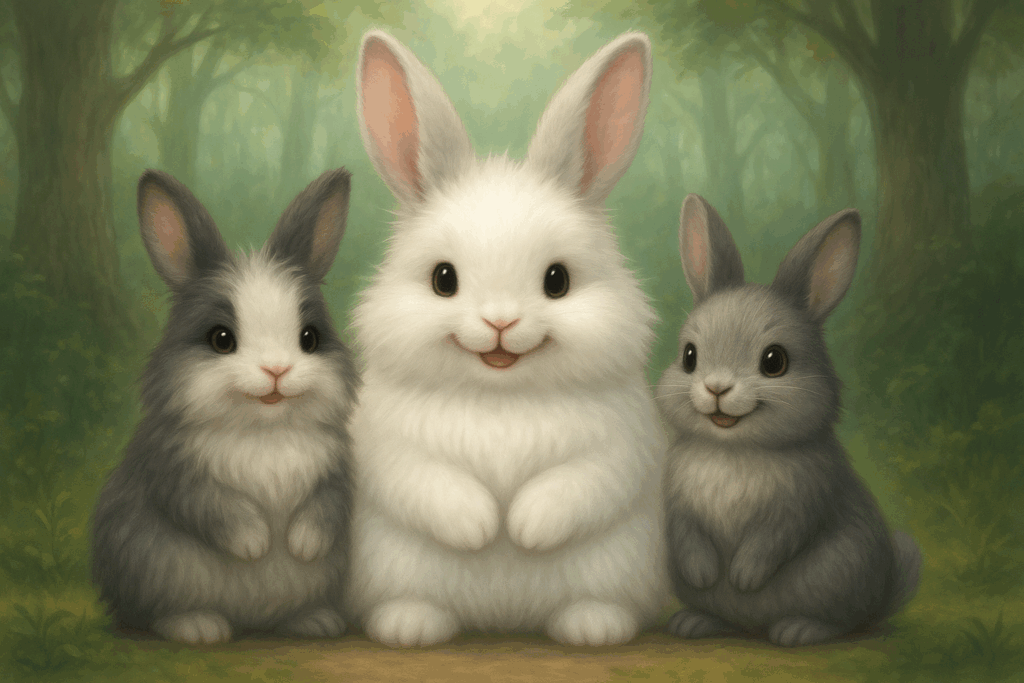

3:ペットが複数いる時は?

人間のキャラもそうだと思いますが、ペットだって1匹だけじゃなくて色々出したいですよね。

でも、MidJourneyのOmni Referenceは1画像しか添付できない!

アップデートされたらより複雑に設定できるようになるかもしれませんが、現時点では1枚。

ならば、ChatGPTで例えば3匹のペットのイラスト画像を生成し、

3枚のペットイラストをChatGPTに添付し、

1枚の画像にして!とお願いすればいいのです。

そうすると、とんでもなくかわいい画像がでてくることでしょう。

私は最初感動しすぎて、コンビニの印刷コーナーに走りましたね・・・。

そして、できた三位一体の画像!ドーン

※これはちょっと失敗したやつですけども。。

1枚の絵に複数の動物を登場させたい場合、

これを毎回、Mid Journey v7のOmni Referenceに差し込んで作っていきましょう。

ついでに覚えておくと便利!ChatGPT 生成IDの管理方法

ChatGPTで「この絵いいな!」と思っても、時間が経つと、再現が難しくなります。

画像を引用元にしてこの画像のニュアンスで~などと依頼しても、

直近の画像を参照したりしてしまいます。

画像生成については、短期的にしか記憶してないようです。

そんな時のために、生成ID(seedやJob ID)をしっかり記録するようにしましょう。

やり方は、ChatGPTで出力された画像が気に入れば、その直後に、

「今の画像のPrompt/Seed/Gen IDを教えて」と言うだけです。

そうすれば、時間が経った後でも、ChatGPTで過去の画像に似せて

また別のPromptを上乗せして画像生成できたりして便利です。

そのため、Midjourneyを使わず、ChatGPTだけでも、

十分一貫性を保ったキャラが出せるようになっているとも言えます。

今日のまとめと次の一歩

今日はMidJourney v7の進化に触れつつ、キャラ固定の感覚がつかめたこと、

そしてChatGPTとの連携によるプロンプト精度の向上についてまとめました。

では、また!

⭐よかったら本サイトのほう、見てね。

https://mofu.link/